L'IA s'en va-t'en guerre. Entretien avec Laure de Roucy-Rochegonde

L’IA transforme profondément le champ de bataille en intégrant tous les aspects de la guerre moderne, de la logistique au renseignement, en passant par la désinformation et les armes autonomes. Cette évolution soulève une rupture éthique majeure, en ce que les principes traditionnels de la guerre, fondés sur l’agentivité humaine, deviennent obsolètes face à des systèmes capables d’identifier et d’éliminer des cibles sans intervention humaine.

En quoi l’IA modifie-t-elle, ou non, le champ de bataille et la perception de la guerre ?

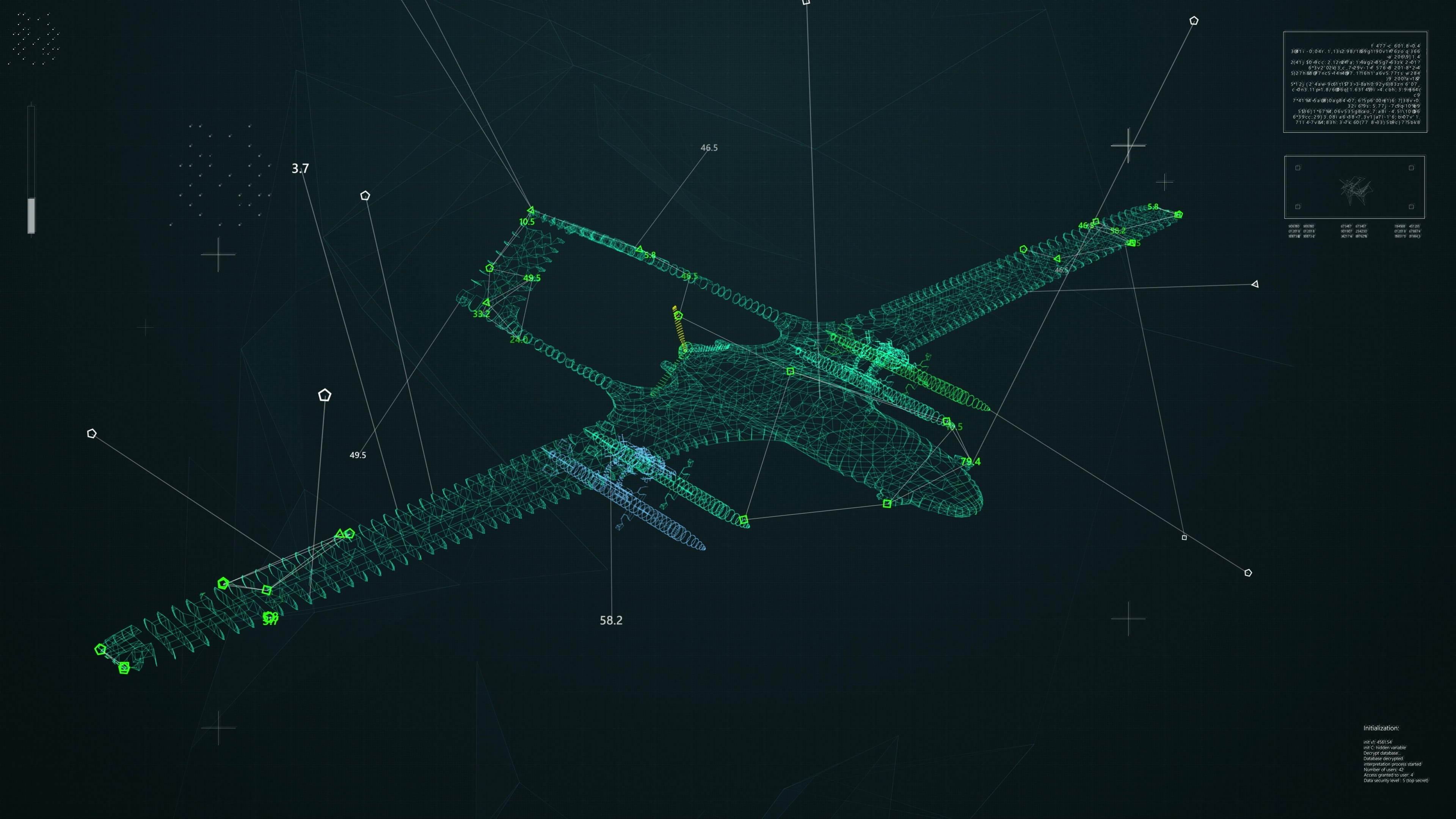

Laure de Roucy-Rochegonde — Certains prétendent que l’usage de l’intelligence artificielle ne change rien, ce qui me laisse perplexe. Je pense au contraire que l’IA change la donne. D’abord parce qu’elle est utilisée et intégrée dans tous les systèmes de force contemporains, du moins dans les armées modernes. Cela va de la logistique et la maintenance à la santé, au renseignement et à tout ce qu’on appelle la lutte informationnelle. Elle fait le lien avec la guerre cognitive, la désinformation, les manipulations de l’information. Mais le point le plus important à mes yeux est son usage pour rendre autonomes des systèmes d’armes capables d’identifier une cible et d’ouvrir le feu sans intervention d’un opérateur humain.

C’est une rupture éthique ?

L. de R.-R. —Certainement. Trois grands corpus ont été utilisés pour penser la guerre. Le premier est l’éthique de la guerre qui est une tradition à l’origine liée à la théologie. Le deuxième est le droit de la guerre qui en dérive très naturellement et en fait une sorte de traduction des principes éthiques en droit. Le troisième, c’est la stratégie militaire qui est aussi une théorie de la limitation de la violence, que ce soit pour dissuader l’adversaire, recourir à la force ou gagner la guerre le plus rapidement possible et donc cesser d’user la force.

Texte citation

Ces trois corpus ont été pensés pour une agentivité humaine, avec le présupposé implicite que c’est un humain qui doit appliquer ses principes éthiques, ses règles de droit, ses objectifs stratégiques.

Directrice du Centre géopolitique des technologies de l'Ifri

Mais avec des armes autonomes, l’humain sort de la boucle, l’implicite ne l’est plus et ces corpus ne sont plus pertinents. C’est le cas en Ukraine où l’intégration de l’intelligence artificielle se fait à vitesse grand V, avec, au moins jusqu’ici, une participation active des géants américains de la tech.

C’est l’IA qui permet à un drone de continuer sa mission – par exemple frapper un dépôt d’armes sur le territoire russe – même en cas de perte de liaison avec son opérateur : la particularité de ces engins, c’est d’être à la fois des capteurs et des effecteurs, c’est-à-dire qu’ils peuvent mener des missions mais aussi capter des données, prendre des images et recueillir des sons. Ces capacités ont été couplées avec ce qu’on appelle « l’ open source intelligence » , soit la possibilité d’utiliser des renseignements publics – photos sur Instagram ou TikTok, images satellites de type Google Earth... – qui permettent par exemple d’identifier des mouvements de troupes en croisant les données des comptes de soldats sur les réseaux sociaux avec des images satellites de bâtiments. Autre exemple, côté israélien cette fois : ces programmes d’intelligence artificielle – Habsora, Lavender ou Where’s Daddy? – qui agrègent un très grand nombre de données, croisent les écoutes téléphoniques, les images de vidéosurveillance et les informations publiées sur des réseaux sociaux pour faire des recommandations de cibles. Dans le cas d’Habsora, des bâtiments étaient identifiés comme lieu d’habitation de membres du Hamas, stock de munitions ou encore centre de renseignement du Hamas.

Lavender a plutôt servi à identifier des membres présumés du Hamas en puisant dans les données issues de la surveillance de masse de la population gazaouie puisque même avant le 7 octobre 2023, chaque habitant de Gaza s’était vu attribuer une note de sécurité sur 100, en fonction de la probabilité qu’il fasse partie du djihad islamique, du Hamas ou d’un groupe armé hostile à Israël. C’est à partir de ces informations que les IA proposaient de lancer une frappe. Quant au programme Where’s Daddy?, peut-être le plus polémique, il a servi à repérer les membres du Hamas présumés quand ils étaient chez eux, la nuit, car les Israéliens avaient constaté que le taux de létalité était meilleur dans ce cas. Au risque de faire beaucoup plus de victimes collatérales parmi leurs familles et voisins.

[...]

Lire en intégralité l'interview de Laure de Roucy-Rochegonde dans Philosophie Magazine

Média

Journaliste(s):

Format

Partager